Jazda do Hľbky Výkonu: Ako GPU Revolutionizujú Modelovanie Jazykov

GPU transformujú jazykové modelovanie vďaka paralelnému spracovaniu, optimalizácii pamäte a technikám ako flash attention. Zistite, ako vylepšujú výkon AI!

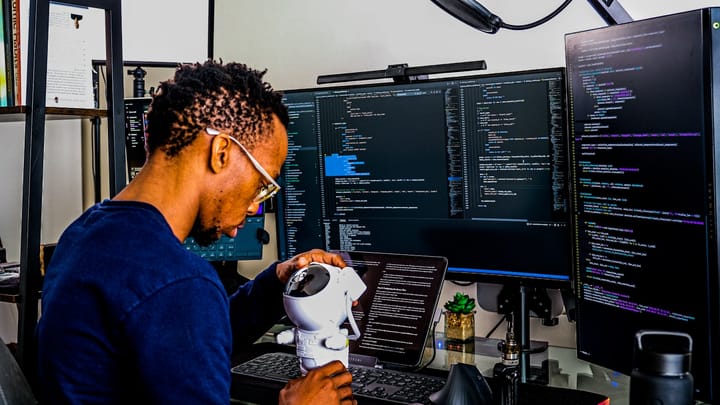

Vítajte na fascinujúcej ceste do zákulisia výkonu a účinnosti moderných jazykových modelov. V dnešnej dobe, keď sa umelá inteligencia preniká do mnohých sfér nášho života, je dôležité pochopiť, ako presne tieto technológie fungujú a čo ich poháňa. V tomto článku sa bližšie pozrieme na prednášku z kurzu Stanford CS336 o modelovaní jazykov, kde sa prelínajú teoretické koncepty s praktickými aspektmi implementácie na GPU (grafických procesoroch).

Kľúčové poznatky

- Výkon GPU: Základom úspechu moderných jazykových modelov je ich schopnosť efektívne využívať výkon GPU, ktoré sú navrhnuté na paralelné spracovanie veľkého množstva úloh.

- Zloženie GPU: GPU sú rozdelené na malé jednotky, tzv. streaming multiprocessors (SM), ktoré umožňujú vykonávanie viacerých operácií súbežne.

- Význam pamäte: Okrem výpočtovej sily sú pre výkon zásadné aj správne stratégie práce s pamäťou, pretože rýchlosť prístupu k pamäti je často úzkym miestom výpočtov.

- Optimalizácia algoritmov: Používanie techník ako návratná výpočtová stratégia, zlučovanie operátorov a nízka presnosť môže výrazne zlepšiť výkonnosť algoritmov.

Anatomia GPU a jej Význam

GPU majú veľmi odlišnú architektúru ako CPU. Kým CPU sú optimalizované na nízku latenciu, GPU sú navrhnuté pre vysoký výpočtový výkon, kde paralelné spracovanie veľkého množstva dát umožňuje dosiahnuť vysokú účinnosť. Kľúčový rozdiel spočíva v množstve výpočtových a kontrolných jednotiek, kde GPU obsahujú množstvo malých výpočtových jednotiek, ktoré dokážu spracovávať dáta paralelne.

Rôzne Typy Pamäte a Ako sa Využívajú

Rýchlosť výpočtov na GPU je do veľkej miery obmedzená tým, ako efektívne dokážu prístupy k pamäti. GPU obsahujú niekoľko vrstiev pamäte, od najrýchlejšieho L1 cache až po globálnu pamäť DRAM. Efektívne využívanie týchto vrstiev je kľúčové na minimalizáciu latencií a maximalizáciu výpočtovej efektivity. Pochopenie, ako správne implementovať pamäťové prístupy a ktoré operácie môžu byť lokalizované na GPU, je základom pre optimalizáciu.

Techniky Optimalizácie Výkonu

Návratná Výpočtová Stratégia (Recomputation)

Táto stratégi predstavuje výmenu prístupu k pamäti za dodatočné výpočty. Namiesto ukladania dočasných výsledkov do globálnej pamäti sa tieto výsledky prepočítajú na základe potreby, čím sa šetrí pamäť a zvyšuje sa rýchlosť spracovania.

Zlučovanie Operácií (Kernel Fusion)

Zlučovanie viacerých operácií do jednej umožňuje minimalizovať počet prístupov k pamäti tým, že sa medzi operáciami vyhýba opakovaným zápisom a čítaniam z globálnej pamäti.

Nízka Presnosť Výpočtov

Použitie nižšej presnosti (napr. z float32 na float16) môže výrazne znížiť množstvo dátového toku potrebného pre výpočtové operácie, čo vedie k rýchlejšiemu spracovaniu pri zachovaní prijateľnej úrovne presnosti.

Flash Attention: Spájame Všetky Triky Dokopy

Flash attention je evolučnou technológiou, ktorá využíva všetky uvedené techniky na optimalizáciu výkonu transformátora, základného stavebného bloku mnohých moderných jazykových modelov. Zavádza efektívny spôsob spracovania softmax operácie online, čo umožňuje vykonávať operácie v rámci dlaždíc, bez potreby ukladania veľkých matíc do pamäte.

Vďaka tomu dosahuje flash attention dramatické zlepšenia v rýchlosti a efektivite, čo je kľúčové pre spracovanie veľkých jazykových modelov.

Odporúčania a Záverečné Myšlienky

Pokrok v AI je neoddeliteľne spätý s hardvérom, ktorý tieto aplikácie poháňa. Zvládnutie umenia pracovať s GPU môže byť rozhodujúce pre vývoj efektívnych a škálovatelných AI systémov. Preto je dôležité nielen rozumieť teoretickému základu, ale aj prakticky zvládnuť optimalizačné techniky, ktoré robia moderné jazykové modely možnými.

Odkazy na Štúdie a Dôležité Informácie

Ak vás napĺňa svet umelej inteligencie a chcete sa hlbšie ponoriť do tajov modelovania jazykov, tieto odkazy vám poskytnú cenné informácie a ďalšie zázemie pre váš rozvoj.

Približne 268 gCO₂ bolo uvľnených do atmosféry a na chladenie sa spotrebovalo 1.34 l vody za účelom vygenerovania tohoto článku.

Komentáre ()