Hodnotenie jazykových modelov: nové metódy a výzvy

Hodnotenie rozsiahlych jazykových modelov (LLM) je kľúčové, no náročné. Nové metódy využívajú iné LLM na hodnotenie výstupov, ale treba si byť vedomý biasov a kontaminácie dát. Reálne testovanie zostáva nevyhnutné pre spoľahlivosť modelov.

Prednáška zo Stanfordu CME295 sa venovala komplexnej téme hodnotenia rozsiahlych jazykových modelov (LLM). Zistili sme, že presné meranie výkonnosti LLM je kľúčové pre ich ďalší rozvoj. Prednášajúci predstavil nové metódy, ako napríklad využitie iných LLM na hodnotenie, a zároveň upozornil na bežné problémy a zaujímavé benchmarky v tejto oblasti.

Kľúčové poznatky

- Hodnotenie je kľúčové: Presné meranie výkonnosti jazykových modelov je nevyhnutné pre ich zlepšovanie.

- LLM ako sudca: Použitie iného LLM na hodnotenie výstupov, vrátane zdôvodnenia, predstavuje sľubný prístup.

- Biases a problémy: Je potrebné byť si vedomý rôznych biasov (napríklad pozícia, verbosita, sebahodnotenie) pri hodnotení LLM.

- Benchmarky: Existujú rôzne benchmarky zamerané na rôzne aspekty výkonnosti LLM, od voľnej tvorby textu až po bezpečnosť.

- Reálna skúška je dôležitá: Benchmarky sú užitočné, ale reálne testovanie v konkrétnych scenároch zostáva nevyhnutné.

Hodnotenie jazykových modelov: Prečo je to tak ťažké?

Jazykové modely dokážu generovať rôzne typy výstupov – od prirodzeného textu až po kód. To robí vytvorenie univerzálnych metrík na hodnotenie veľmi náročným. Ideálne by bolo, keby každý výstup hodnotili ľudskí experti, ale to je príliš drahé a subjektívne. Aj ľudské hodnotenie môže byť nekonzistentné, čo ukazuje potrebu jasných kritérií.

LLM ako sudca: Nový prístup

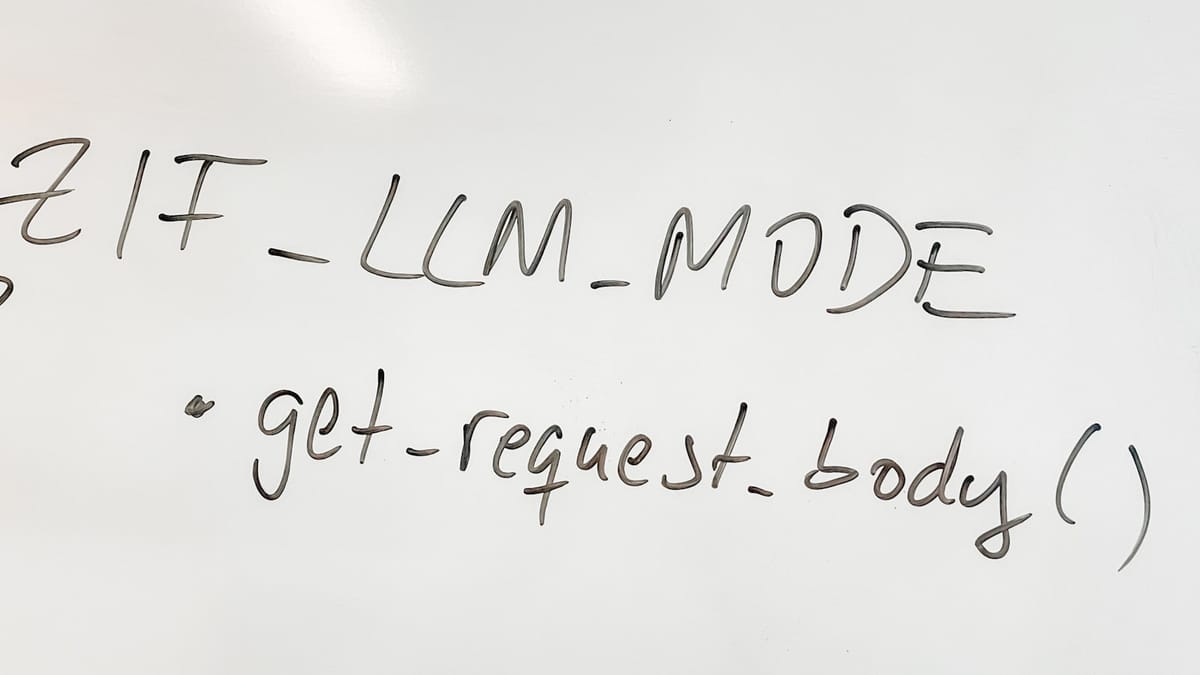

Jednou z najzaujímavejších metód, ktoré predstavili, je využitie iného jazykového modelu na hodnotenie výstupov prvého modelu (tzv. LLM-as-a-judge). Tento prístup má niekoľko výhod: nevyžaduje referenčné odpovede a môže poskytnúť vysvetlenie pre každé hodnotenie, čo je obzvlášť užitočné v porovnaní s tradičnými metrikami, ako BLEU alebo ROUGE.

Aby sa zabezpečila štruktúrovaná odpoveď (napríklad "zdôvodnenie" a "hodnotenie"), používajú sa techniky kontrolovaného dekódovania. Je dôležité si uvedomiť, že aj tento prístup môže byť ovplyvnený rôznymi biasmi. Napríklad, poradie odpovedí môže ovplyvniť hodnotenie (pozícia), modely môžu preferovať dlhšie a detailnejšie odpovede (verbosita) alebo sa uprednostňujú vlastné výstupy modelu (sebahodnotenie).

Biases: Na čo si dať pozor?

Prednášajúci zdôraznil niekoľko bežných biasov, ktoré môžu ovplyvniť hodnotenie LLM. Aby sme ich minimalizovali, odporúča nasledujúce kroky:

- Zmeniť poradie odpovedí: To pomáha znížiť vplyv pozície.

- Používať jasné kritériá: Zamedzuje sa preferovaniu verbóznych odpovedí.

- Vyhnúť sa používaniu rovnakého modelu: Pri hodnotení by mal byť použitý iný model, aby sa predišlo sebahodnoteniu.

Benchmarky: Ako merať výkonnosť?

Existuje množstvo benchmarkov na meranie rôznych aspektov výkonnosti LLM. Niektoré z nich sa zameriavajú na voľnú tvorbu textu (LLM-as-a-judge), iné na logické uvažovanie (AIM, PIQA) alebo programovanie (SWE-bench). Nedávno bol predstavený aj Gemini od spoločnosti Google a s ním spojené benchmarky.

Je dôležité si uvedomiť, že výsledky benchmarkov môžu byť ovplyvnené kontamináciou dát – keď model videl trénovacie dáta z benchmarku počas tréningu. Preto sa používajú rôzne techniky na zmiernenie tohto problému.

Zamerajte sa na reálne použitie

Benchmarky sú užitočné nástroje, ale nemali by byť jediným kritériom pri výbere jazykového modelu. Je dôležité zvážiť konkrétne potreby a scenáre, v ktorých bude model používaný. Prednášajúci upozornil na „efekt merania ako cieľa“ – keď sa modely optimalizujú len pre benchmarky, čo môže viesť k strate praktickej použiteľnosti.

Záver

Hodnotenie jazykových modelov je komplexný a neustále sa vyvíjajúci proces. Nové metódy, ako napríklad využitie LLM na hodnotenie, ponúkajú sľubné možnosti pre presnejšie meranie výkonnosti. Je však dôležité byť si vedomý potenciálnych biasov a reálne testovanie zostáva nevyhnutné pre zabezpečenie spoľahlivosti a použiteľnosti týchto modelov.

Zdroje

- Originálne video

- online.stanford.edu

- Plán kurzu

- Stanford CME295: Transformers and Large Language Models I Autumn 2025 - YouTube

Približne 207 gCO₂ bolo uvoľnených do atmosféry a na chladenie sa spotrebovalo 1.04 l vody za účelom vygenerovania tohoto článku.

Komentáre ()